Этика и ИИ: как ChatGPT вредит креативной и бизнес сферам

Первую демоверсию чат-бота ChatGPT (Generative Pre-trained Transformer) компания Open AI выпустила 30 ноября прошлого года. Он является практически уникальным примером генеративного ИИ, умеет создавать текст, фото, видео и другие виды медиа на основе той базы, которые ему дали разработчики. Другими примерами этого типа ИИ являются Midjourney, который генерирует изображения, AutoSlide, который создает презентации, и AlphaFold — его используют в медицине для предсказания структуры белка.

На фоне популярности ChatGPT возникает вопрос об этическом использовании виртуальных помощников в нашей повседневной и профессиональной жизни. В этом материале мы рассматриваем его влияние на контент-мейкеров, мир бизнеса, а еще предлагаем пути решения проблемы с помощью эксперта в области ИИ Екатерины Бахмутовой.

Чем ChatGPT не устраивает контент-мейкеров

Использование ИИ для создания контента может привести к нарушению авторских прав. Сгенерированные тексты или изображения часто сильно напоминают уже существующие работы. То же касается и студенческих работ, написанных чат-ботом, — в них «заимствования» выявить еще легче при помощи специальных детекторов. В целом, проблемы ChatGPT в креативной сфере схожи с проблемами гострайтинга (ghostwriting), то есть написания текста для и от имени другого человека.

Американские писатели Пол Тремблей и Мона Авад даже начали судебное дело против OpenAI. Они утверждают, что компания нарушает авторские права, когда обучает свою нейросеть на основе оригинальных ресурсов, включая их книги. Всё это делается без разрешения авторов.

86% профессиональных криаторов позитивно оценивают влияние ИИ на их творчество, потому что так они экономят деньги и время. Однако, многие ставят под сомнение его позитивное влияние на креативную часть работы. Генеративные ИИ могут создавать творчество на основе таких данных, как цвет, размер, расстояние, форма. Так, ChatGPT может написать хокку о Солнце, зная, что это большая, горячая, круглая, далекая от нас звезда. Но ИИ способен творить, лишь на основе той информации, которую в него вложили разработчики. Он (пока) не способен иметь собственные мысли, идеи, чувства — всё то, что делает наше творчество таким неповторимым.

Какие проблемы для бизнеса создает ChatGPT

Генеративные ИИ в целом полезны для бизнеса, например, при обучении сотрудников английскому языку. Несмотря на это, они могут работать и против людей. Новые технологии исторически всегда вызывают недоверие и страх замены среди работников. Эти опасения подкрепляются фейковыми новостями о том, что нейросеть якобы «уже уволила 35 миллионов человек». ChatGPT также представляет риск для компаний, которые могут столкнуться со «лжеэкспертностью» своих сотрудников, которые злоупотребляют ИИ на рабочем месте.

К тому же, существует риск сбора и обработки персональных данных без согласия пользователей. Так, информационная база ChatGPT составляет более 300 миллиардов слов, извлекаемых из книг, веб-сайтов, архивов, различных медиа-порталов. При этом, у пользователей не спрашивают их разрешения и не уведомляют об использовании их данных для запросов других пользователей. С этой проблемой столкнулась компания Samsung Electronics после того, как ее неосторожные инженеры загрузили в нейросеть исходный код одного из продуктов. Это привело к большой утечке чувствительной информации, после чего компания запретила использовании ИИ с корпоративных устройств.

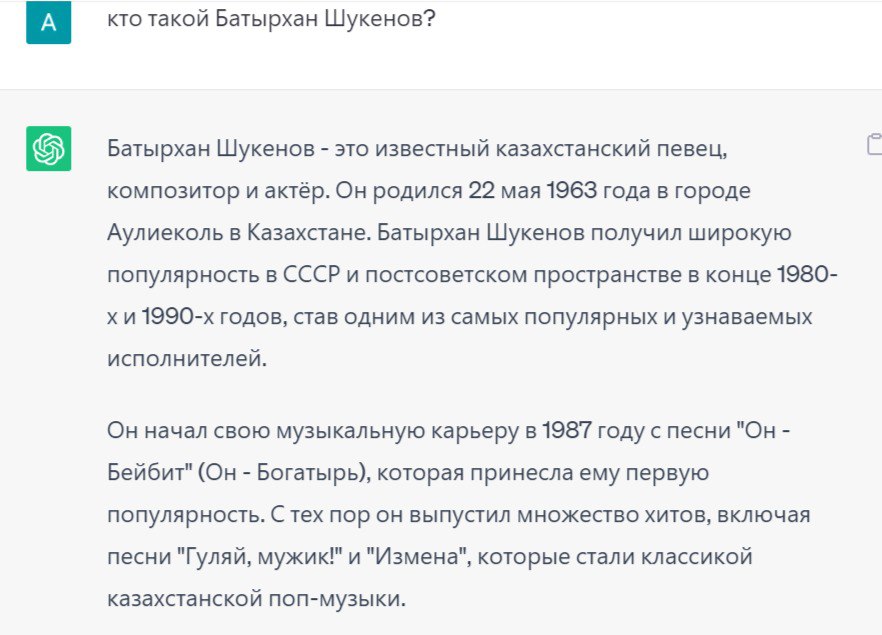

Кроме того, если не проверять тексты, написанные нейросетью, можно легко вызвать недовольство заказчика: сами создатели OpenAI предупреждают, что их творение «иногда дает правдоподобные, но неверные или бессмысленные ответы». Например, мы спросили у чат-бота, кто такой Батырхан Шукенов, на что он ответил, исказив факты:

Опасность этой особенности чат-бота видна из происшествия с профессором права Джонатаном Тёрли. Его коллега попросил ChatGPT выдать ему список юристов-ученых, когда-либо замешанных в сексуальных преступлениях. В списке нейросети значился и Тёрли, который никогда ни в чём подобном не обвинялся.

А мэр австралийского города Хепбёрн Шайр даже хотел подать в суд на нейросеть за то, что та выдавала о нём неверную информацию, а именно о его причастности к взяткам.

Как уберечь себя от Chat GPT и продолжить им пользоваться

Столкнувшись с этими рисками, некоторые учебные заведения и компании официально запретили использование ChatGPT. Другие внедряют нейросеть в свою рабочую рутину на определенных условиях. Екатерина Бахмутова, докторантка Уэстклифского университета Калифорнии и специалистка в области ИИ и STEM, утверждает, что это зависит от уже существующей политики заведения и его подхода к управлению информацией.

Учреждения могут разграничить работу человека и нейросети, если пропишут в своей политике границы использования ИИ и утвердят проверки на плагиат. Например, ведущий французский университет Sciences Po Paris требует у студентов указывать ChatGPT как один из первоисточников, а иначе им грозит исключение. Гарвард и вовсе собирается запустить своего чат-бота-учителя. «Этот подход способствует ответственным инновациям и гарантирует, что преимущества ИИ будут использованы при минимизации потенциального вреда», — комментирует Екатерина. Очень важно и юридическое регулирование данного вопроса.

«Основа для сотрудничества человеческого разума и ИИ — наличие законов, которые объясняли бы, как можно и нельзя пользоваться ChatGPT», — объясняет специалистка.

В свою очередь, работники и студенты могут пользоваться нейросетью для выполнения базовых задач. На основе информации от чат-бота они могут раскрывать и дополнять свои идеи. Главное — соблюдать академическую и профессиональную честность, даже если шансы быть пойманными невелики.

В наши дни невозможно игнорировать новые технологии, не поддаваться искушению и не использовать ChatGPT. Несмотря на проблемы ИИ, совместная работа человеческого и искусственного интеллекта может привести к большим результатам.